AIが勝手に映像を編集? 映像自動編集の仕組みに迫る~TIPSTARの開発の裏側 #2~

ミクシィでは2020年6月末に、新感覚スポーツベッティングサービス『TIPSTAR(ティップスター)』をリリースしました。『TIPSTAR』は365日配信されるライブ動画と、現在は競輪(KEIRIN)を友達と一緒に楽しむことができるサービスです。

ユーザーの皆さんにサービスをより楽しんでもらうため、レース映像にタイムリーにテロップやアニメーションが流れています。TVの生放送などを見ていても画面の右下に番組タイトルが反映されていたり、アニメーションでの演出を施していたりしますが、通常は手動で行うケースがほとんどです。『TIPSTAR』ではその編集作業を人の手ではなく、AIによる自動化を一部に実施し、レースにあわせてテロップやBGMが流れる仕組みになっています。(※特許申請中)AIを用いて映像の自動編集の仕組みを取り入れた開発について、担当の橋口(写真左)と馬淵(写真右)にインタビューしました。

【TIPSTARの技術について】

♯1「低コストで高品質って両立できるの? 『TIPSTAR』の“映像伝送システム”の仕組みとは」

映像編集の簡易化・自動化を実現したい

――まず『TIPSTAR』に映像自動編集の仕組みを取り入れた背景から聞かせてください。

馬淵 『TIPSTAR』で扱っている競輪のレースは365日、全国の会場で開催されます。1会場当たり1日で平均10回ぐらいのレースがありますし、それが全国で毎日10会場、年間に換算すると数万回レベルで開催されているわけです。

――すさまじい量のレースが開催されているわけですね。

馬淵 そうなんですよ。事業設計の段階からすべてのレースで生の映像を編集していく方針でしたから、現場で映像を編集する方には、すさまじい運用負担がかかるだろうなと。その課題を解決するために、編集の自動化プロジェクトがスタートしました。

橋口 2019年の10月頃からスタートしましたね。当初はTV局が行っているように、ボタンをおしたら予め用意しておいたテロップが出るみたいなものを想定していました。それをAPI化してみようかというところから検証を始めました。

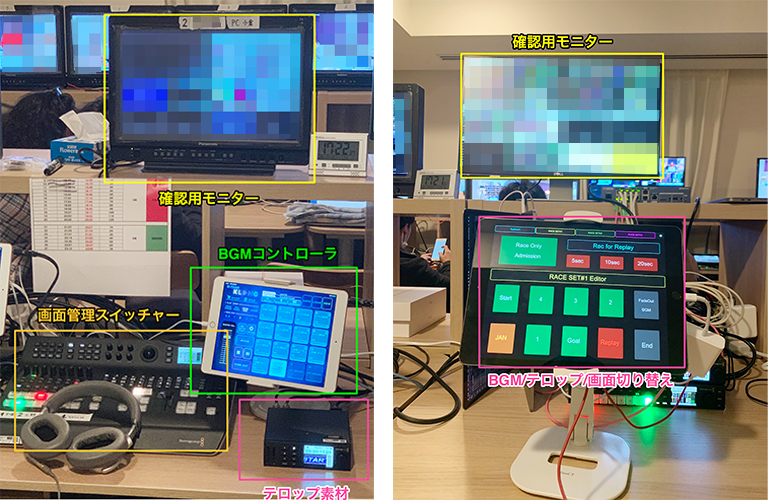

馬淵 一般的には物理機器をおいて撮影しているスタジオ等で、映像を見ながら編集するというのがセオリーです。これがまず大きな課題でした。自動化を検討した際に、物理ボタンを押すロボットを作るわけにはいかないし(苦笑)。なので、物理的な制約はなるべく除去して、アプリケーションレイヤーのソフトウェアで解決できないかと。そうすればどこでも誰でもできますからね。

――確かに通常だと、映像編集用の機器、音声用の機器、モニター、スイッチャー、ケーブルなどの機器を揃えるのに加え、人的リソースもかかりますね。

馬淵 1レース毎にその機材もろもろと人とのリソースが必要となり、同日に10会場で開催されたとしたら、極端な話10セット必要になる。そうなるとコストの観点からも、サービススケールがなかなか難しくなってきますよね。

橋口 仮にそのセットを用意できたとしても編集は、人的スキルによりますから効率は悪いでしょうし、その分の編集スタッフの人材確保や機器のメンテナンスなども必要でしょうから。

馬淵 そのためタブレット端末の画面に複数のボタンを表示してポチポチすると、該当するテロップが映像に表示されたり、演出できたり…を想定していました。一ヶ月ぐらいで、試作機を作って編集の簡易化を試みたんですが、現場の編集担当からは「人が一人削減できるほどの便利なツールにはなってはいないですね」と厳しい声をいただきまして(苦笑)。

――なんと…。

馬淵 レース映像の編集は、割と同じような編集を繰り返す傾向があります。しかし、各会場ごとにレース映像は異なりますし、ツールに柔軟性を持たせつつも、それをどうにか簡略化していきたいわけです。しかし初期は全然うまくいかなくて……。そこで、編集の簡易化ではなく、自動化を検討したわけです。

――なるほど。どのように取り組まれたのでしょうか。

馬淵 古典的な画像解析の手法を手探りで進めていきました。一個のモデルで全てが網羅できるものをイメージはしていましたが、その通りにはいかず。というのも先ほども述べました通り、会場ごとに条件が違うわけです。周回数の長さも違いますし、設置してあるカメラの個数や映像が映る角度も違うわけです。そうなると、汎用的なモデルが作りこめない。あとは私自身、機械学習を現実世界でどううまく組み込んでいくのか勘所が不足していたのも大きく、うまくいきませんでした。

――機械学習をサービスにマッチさせるための壁があったわけですね。

馬淵 そうですね。運用面を考えながら設計しなければならない、と痛感しました。なので、AIを取り入れて編集するという大きな目標はもちろん視野に入れつつ、まずは映像編集をソフトェアで制御する部分のブラッシュアップを進めていきました。制御の基盤的な部分をしっかりと実装し、ソフトウェアベースで安定した編集ができるということが、AIで編集をスムーズに行う上でも重要であり、将来のサービスのスケールアップとコストダウンを両立させていくと信じてましたから。

AI実装・・・しかし

――AIをサービスに取り入れるというのは、簡単にはいかないもんなんですね。

馬淵 そうなんですよ。困った状況が数ヶ月続いたのですが、そこに実サービスにAIを取り入れた実績のある橋口さんがジョインしてくれたことで、課題がぐっと解決に近づきます(笑)。

橋口 以前の部署で、AIの仕組みをプロダクトに盛り込み、サービスを実用化していました。その経験が活きると思いジョインした感じですね。最初は競輪という競技の理解や、レースがどのように行われているかなどについて理解に努めました。もちろん、「AIをどうにか導入できないか」という話は聞いていましたから、どう実現しようかと模索を開始しました。GPUを使ってやるか、他を検討したほうがよいのかなど。

――具体的にどうしたのでしょうか。

橋口 最初の想定では、レース会場から届いた映像データをユーザーに配信する前にあえて数秒遅延させ、その間に機械学習を挟んでAIのモデルを組むことを想定していました。数秒間でAIが映像を解析して、最適なテロップやBGMを流すような形です。しかしこれがインフラの冗長構成の観点で、難しいことが発覚しまして。遅延をいれてしまうと、トラブルが発生した場合、映像が全部落ちてユーザーに映像そのものを届けられないことがわかりました。

馬淵 ちょっとできるかどうか、試してみたんですけどね。リリースも控えており時間がなかったのもあってですね……。

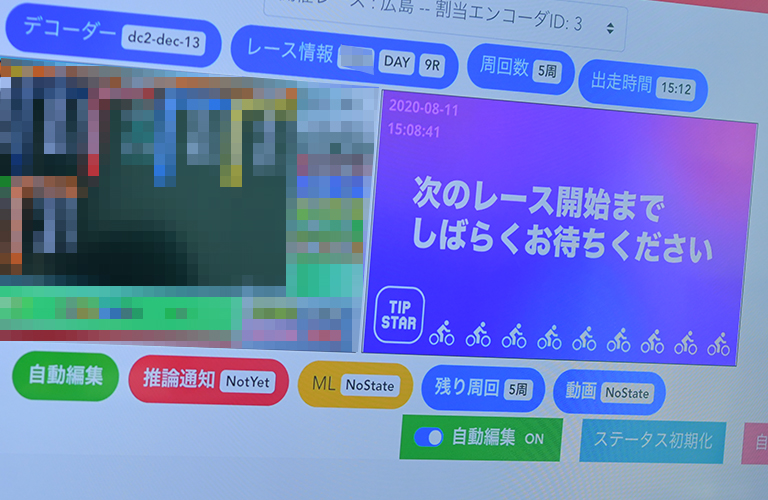

橋口 ということで、遅延させるのは難しいとなったので、リアルタイムで推論しなきゃいけない。もちろんGPUやGPUサーバを各レース会場分揃えるとなるとコストも膨大になる。採用したのは35ドル程で入手できる推論に特化した『Edge TPU』でした。レース映像と会場の音を複合させて、リアルタイムで推論し、レース状況を推定する仕組みにしました。例えば先ほどの話であった、全会場を網羅した汎用的なAIモデルではなく、会場ごとに特化したAIモデルを作成するやり方に切り替えました。

・技術構成:Python + TensorFlow Lite + Edge TPU(ASIC)

・リリースまでの期間がわずか一ヶ月弱だったためスピード重視

・学習はCloud AutoML Vision Edge、推論はEdge TPUで行っている

・画像 + 音からレースの状態を推論

┗音はメルスペクトログラム画像化して学習・推論

┗モデル構造はMobileNetV2をベースに、少量のカスタマイズ

┗Edge TPUに最適化して使用(学習後、モデルはINT8ビット量子化され、1つのOperationにまとめられる)

・レース状態に応じて映像編集API(以降、BC)から編集

この仕組みによって、例えば、現地でファンファーレが流れたら、サービス用のオリジナルのファンファーレBGMが流れますし、最終ラップの鐘が鳴る、選手が入場するなどでテロップが自動で表示されます。レースの状況によって、予め設定しているデザインの画面表示が実現できるようになっています。多少の映像との若干のズレは発生していますが、レース映像として違和感ない程度の粒度で、AIが自動編集しています。

――これは、すごいですね。この仕組みを導入する際に、難易度が高かった点などはありますか。

橋口 一つは、スケジュールですね。Webアプリのリリースが6月末で決まっていまして、AIの仕組み導入において遅延の仕組みが難しいとわかったのが、6月初旬。そこから1ヶ月弱で対応するのは、大変でした。オンプレに『Edge TPU』のPCIe版を載せて検証などをしていましたから。

――その他にもありますか。

橋口 音推論ですね。例えば、号砲(ピストル音)が鳴ってレースがスタートしますが、汎用的なピストル音を学習させたらイケると安易に考えていたのですが…。これが思ったよりも上手くいかない。会場ごとにピストル音の性質が異なっており、更には、その日の会場のマイクの調子によって号砲音も微妙に異なっていたんですよね。また、リアルタイム推論が求められたことで誤検出が許されないこともありました。それもあって、会場ごとにデータセットを作って、AIのモデルを作成することにより、誤検出を抑制できればと考えました。

映像編集のAI化の先駆けとなるように

――もう全会場分のモデルはあるのでしょうか。

橋口 いやまだです。ML OPSの整備が間に合っておらず、10会場程度のモデルを運用することで精一杯です。ML OPSを整備し、自動編集対応会場を増やしていくのも今後の課題です。

馬淵 サービスがリリースして一ヶ月ほど立ちましたが、このAIの仕組みはテストも兼ねて随時現場の映像編集チームに利用してもらっています。いずれは、これまで4会場あれば編集担当として4人必要だったのが、1名で補完できるような形になるのが理想です。

――最終的にはどのような形になるのが理想ですか。

馬淵 そうですね。やっぱり、人の手がそこまで必要ないところはどんどんAIを取り入れて、映像編集担当がもっとクリエイティブなところに注力できる環境にしたいですね。

橋口 技術的な観点でいくと、やりたいことにもよりますが、先ほど話した遅延の仕組みを取り入れて、レース状態の推定をより確実にしたいですね。他には、ML OPSをしっかり取り組みMLパイプラインの自動化やCI/CDパイプラインの自動化などですね。精度が下がったことが自動で検知できたり、原因を誰でもストレスなく探れたり整備する必要があります。

また、競輪の面白さ、ラインやブロック、まくりなどわかりやすく見せられるように、選手の向きや姿勢を推定してケイデンス表示、加速・減速の可視化などにもチャレンジしたいです。そのような改善や取り組みが『TIPSTAR』のサービスユーザーが熱くなれるような演出に繋がるはずですから。

――AI技術によって、スポーツの見え方がこれまでとは変わる期待がありますね。

橋口 その期待はありますね。とはいえ、AIは万能というわけではありませんので、まずは、AIと協調して放送編集の担当の皆さんが楽に仕事ができるようにしていきたいです。近い将来、映像編集のAI化が進むと思っていますから、その先駆けとなるようチャレンジしたいです。

2012年にミクシィへ新卒入社。SNSの検索エンジンの開発・運用を担当した。2013年、社内ベンチャー制度によって株式会社ノハナの立ち上げに参画・創業。『ノハナ』、『ノハナ年賀状』アプリの新規開発や機械学習による画像認識やGCPへのバックエンド移行に従事。『みてね』では、1秒動画における画像認識エンジンを開発。2017年、株式会社スマートヘルスの立ち上げに参画・創業。姿勢推定を用いたプロダクト開発や京都大学医学部との共同研究に参加。現在は『TIPSTAR』で、AI映像編集システムの開発・運用に従事。

国内ISPにネットワークエンジニアとして新卒で入社した後、2018年にミクシィへ中途入社。入社以降、『モンスターストライク』のインフラネットワークの、運用・開発に従事。XDP/DPDKを用いたネットワーク機能開発や、ホワイトボックス機器等の導入検証や設計を実施。現在は『TIPSTAR』で、AI映像編集システムの開発・運用に従事。