MIXIには、探究心溢れるエンジニアがたくさん在籍しています。

その探究心は業務で扱う技術に留まらず、趣味で書いているプログラムだったり、個人的に研究している言語だったりと、自身の気になった技術への追求も留まることを知りません。

そこで、社内のエンジニアに“好きな技術”について、思う存分に語ってもらうシリーズを始めました。

ルールはこの通り。

・業務で使っている技術でも、使われていない技術でもOK

・あくまでも個人的な見解で

・その技術のどこが面白いの

・愛を込めて語り尽くしてもらう

第11回目は、『TIPSTAR』でAI映像編集システムの開発・運用に携わる橋口さんに「Edge AI」の魅力をたっぷりと語ってもらいました!

2012年 新卒入社。SNS mixi.jpの新検索エンジンの開発・運用を担当。2013年 社内ベンチャー制度によって株式会社ノハナの立ち上げに参画・創業。モバイルアプリの新規開発、機械学習を用いた機能開発やGoogle Cloudへのバックエンド移行に従事。『みてね』では、1秒動画における画像認識エンジンを開発。2017年 株式会社スマートヘルスの立ち上げに参画・創業。姿勢推定を用いたプロダクト開発や京都大学医学部と共同研究講座を開設。並行して現在は『TIPSTAR』で、AI映像編集システムの開発・運用に従事。

“機械学習”専用のデバイス?

━━橋口さんが今アツいと感じられている技術について教えてください!

「Edge AI」ですね。

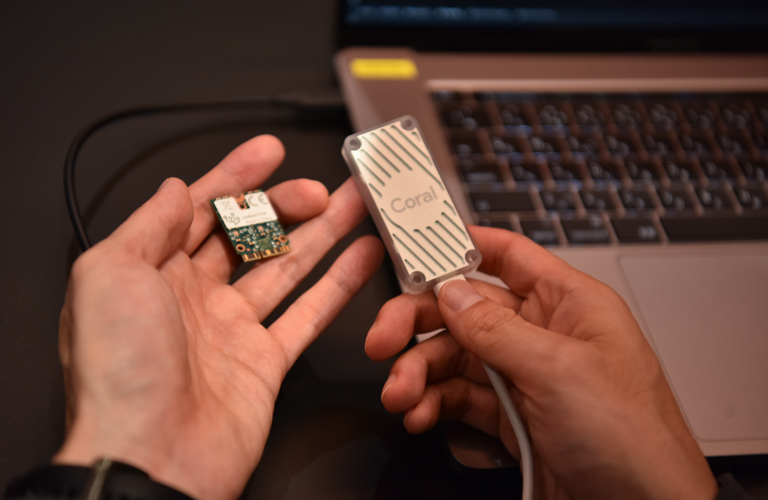

書いて字のごとく、エッジでAI処理を実行するデバイスや仕組みのことです。エッジコンピューティングの一種で、AI処理に関係したネットワーク通信を極力減らし、エッジのみでほぼAI的なシステムを完結するもののことで、Edge AIを実現するハードウェアや専用チップ(AIアクセラレータや専用のASIC)を各社様々な形で販売しています。クラウドで処理するAIと比べて、リアルタイム対応が可能なんです。各社様々なEdge AIデバイスを販売しているのですが、これはGoogleがCoralというブランドで販売している「Edge TPU」というもので、2019年3月に販売開始され誰でも購入できます。通常、AI処理に使用するGPUは数十万円以上することが多いですが、これはUSBアダプタ付きのもので約8000円ほど(記事作成の11月末時点で$59.99)。サーバーに直に接続するものであればもっと安く購入できるんです。

━━おお…!小型のGPUのような…?

GPUはあくまで画像操作や画像特性の計算に特化したハードウェアです。TPUなどのAI処理に特化したハードウェアもあって、そちらの方がGPUよりも優れた性能を得られたり、高効率だったりします。それの小型版というのが概ね正しいと思います。限られたAI処理のみに特化しているので、速く、低電力でかつコストも安いということですね。

━━具体的にはどのような場面で使われているのでしょうか?

身近なEdge AIだと、最近のスマートフォンにはAI専用チップが搭載されていて、カメラアプリで撮影した画像をAIによってより良くしていたりします。自動運転レベル1以上を実現した車載システムだと、車線はみ出し抑制機能だったり、レーンキープ(車線中央維持)など、実は身近なものに搭載されています。

最近2人目が生まれたので、見守りカメラとしてEdge AIが搭載されたネットワークカメラを5000円程度で購入しました。人体検出で人を検出してくれるので、赤ちゃんが起きて動いたら知らせてくれますし、泣き声を検出してアラートを出してくれます。ほかにも犬猫検出もあって、検出体を追跡してカメラを上下左右3D回転する機能もあり、ペット見守りカメラとしても活躍しそうでした。

車系でも多く使われています。2021年11月から販売される自動車への衝突軽減ブレーキが義務化されました。車に搭載されたカメラやセンサーを使って、障害物や先行者、歩行者を検知して距離を推定し、衝突の危険性が高まったら警告音や自動ブレーキを作動させ衝突を回避するシステムです。そうした機能の裏にはEdge AIが使われていることがほとんどだと思います。

━━他にはどのような特徴がありますか?

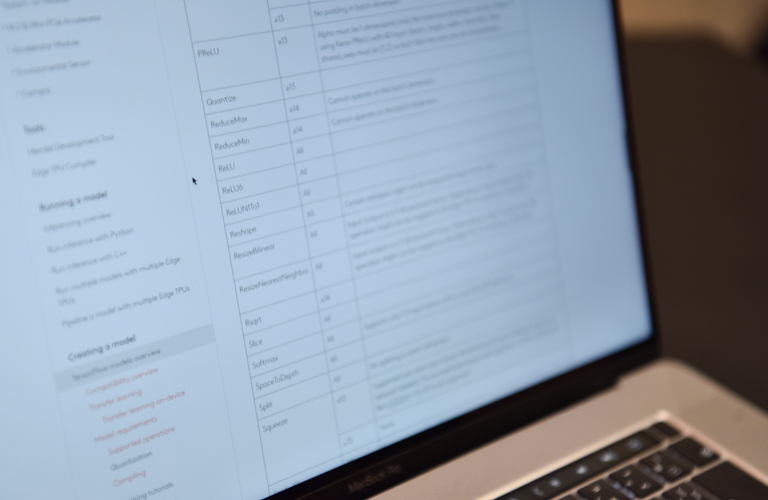

Edge TPUでいうと、すべてのAIモデルを実行できる、というわけではなくEdge TPU専用に処理できる範囲がごく限られているので、特殊な使い方をすることはあまり出来ないように思います。ただ、その代わりにオーソドックスなAI処理であれば超高速な処理が可能で、消費電力もGPUに比べて圧倒的に低く、USBからの給電で駆動できるほど超低電力で動かせるので、運用コストもぐっと抑えられる画期的なものなんです。

これはあくまでも例えですが、GPUが全ての駅に止まれる「各停」列車だとすれば、このEdge Deviceは特定の駅しか止まれないけどスピーディに移動できる「特急」列車のようなもの、という感じでしょうか。

━━なるほど。

メリットはたくさんありますが、特にコスト面に及ぼす影響は大きいと思います。

例えば、「店頭で身体を認識して、動きを評価する」といったサービスがあったとします。従来であれば、店頭のカメラで動画を撮影しサーバーにデータを送って、クラウドでAI処理等をして送り返す…といった流れでやっとユーザー側に反映されていたんです。これが小規模なサービスならあまりコスト面も気になりませんが、ユーザー数が増加していけばいくほど、処理を行うGPUが必要になり、コストもかさんでいきますよね。でも、Edge AIはエッジ側で処理を行うため、取得した動画データを送る必要がなく、店頭側だけで処理が済むので莫大なクラウド費用やGPUが必要なくなるんです、サービスで扱うGPUの規模で行くと数百万、数千万のコスト削減になり、さらに処理も速くなる。大量の処理が必要になるサービスにこそ、うってつけな技術なんです。

『TIPSTAR』でも…

━━実際に業務の中でも使われているんでしょうか?

『TIPSTAR』の映像編集で実際に使っています。『TIPSTAR』では、競輪とオートレースのリアルタイム映像配信を行っており、映像テロップや演出エフェクトを出す編集作業をリアルタイムにAIが行っています。配信映像は、全国48会場からデータセンターに集約されており、Edge AIで使われるチップをサーバに搭載して利用しています。

━━あえてEdge AIをサーバに搭載しているのですね?

全国48会場にEdge AIを設置すると、故障時のメンテナンスコストが高くなってしまいます。また、毎日レースが開催されているわけではないので、その日に開催されている映像が通る一番端っこ(エッジ)がデータセンターであったというわけです。リアルタイムな映像編集を行うAI処理は、Edge AIが得意とする低遅延処理と相性が良かったわけです。

━━まだまだ進化の最中という部分もあるのでしょうか?

そうですね。発展途上にあるというよりは、スマートフォンに搭載されるCPUでもなくGPUでもないAI専用のチップなので、小型GPUであるNVIDIA Jetsonシリーズよりも小さなAI装置なんですよね。iPhoneでいうとNeural Engine、Google PixelでいうとGoogle Tensorがそれに相当します。市場のニーズに対して、専用チップが生まれていると思うので、今後の発展に沿ってAI専用チップも進化していくのではないでしょうか。

━━Edge AIがより進化していくとどのようなことが可能になるのですか?

高価なGPUに近づいていくような進化をすると、生成系AIがエッジで実現できると面白いかもしれません。生成系AIとは、文章、音楽、動画像などのメディアコンテンツをAIが生成するのが特徴です。TIPSTARのリアルタイム映像編集AIは、分類としては認識系AIで、映像をAIが見てレース状態を認識して予め決まっているテロップや演出エフェクトを足すような編集をしています。生成系AIはレース映像をAIが見て、まったく新しい映像を生成するような振る舞いをするので、それはもうすごいことになるんじゃないでしょうか?(笑)

まるでSFの世界のような技術がすぐそこまで来ているように思います。これがエッジで誰でも手軽に出来るようになるともっと夢がありますよね。

━━ワクワクしますね…!逆に、こうなったらいいのにと思う部分もありますか?

この技術にもっと興味を持って開発に取り組んでくれるエンジニアが増えて欲しいですね(笑)。そうすればもっと技術の共有も進むし、加速していけると思うので。

━━そうですね。また数年後に、どんな進化を遂げているか話を聞かせてください!

ランキング

-

1位

- レポート・お知らせ

- 2022/10/14

〈2022年度版〉「MIXIって今なにやってるの?」→お答えします -

2位

- プロダクト・事業

- 2024/07/31

スポーツ業界にデジタルマーケティングの革新を!MIXIが開発した「FC東京公式アプリ」こだわりポイントを担当者に聞いた。 -

3位

- はたらく人

- 2024/08/05

グループ企業のCHROから転籍入社?! 投資事業推進本部の宮本さんは#なんでMIXIに?24 -

4位

- はたらく人

- 2023/10/31

投資事業部アナスタシアさんが開拓したい「新たな投資領域」とは?~新卒成長の軌跡、その後 #15~ -

5位

- カルチャー

- 2023/01/26

〈2022年度版〉MIXIのサービスと技術スタック(開発環境)についてまとめてみた

-

公式アカウント MIXIではたらく人についてもっと知る